Влияние ссылок на продвижение в 2019 году

Начиная с 2013 года в поисковых системах начались изменения в расчетах траста сайтов. В качестве примера интеграции новых методов расчета появился Яндекс Икс (вместо ТИЦ), а Google перестал обновлять PageRank.

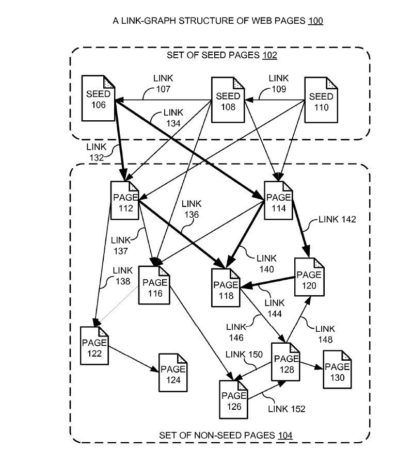

Что общего было у этих алгоритмов? Они использовали ссылочные графы для оценки качества донора и ранжирования сайтов. При этом в Яндексе использовался более совершенный алгоритм учитывающий только тематические ссылки (на то он и тематический индекс цитирования). Тиц и PageRank напрямую влияли на позиции сайтов по поисковым запросам.

Ситуация в Яндексе

Через время алгоритмы начали совершенствоваться, в Яндексе появился Матрикснет и уже стал влиять не только ссылочный вес с ссылок, но и стали учитываться другие факторы (анкор, спам на сайте, релевантность статьи анкору и т.д.). К чему это привело? К тому что переданный ссылочный вес стал резаться при условии что есть какие то негативные факторы влияющие на оценку (к примеру тот же платной ссылки, а не естественной).

В Яндексе с 2013 года после введения влияния поведенческих факторов на выдачу кроме ссылочных факторов начали использоваться и другие методы оценки (например те же коммерческие факторы). Как следствие влияние ссылочного стало все хуже и хуже, та как основная доля траста стала смещаться в сторону коммерческих факторов (для коммерческих запросов) и поведенческих (для информационных).

Мое мнение – сейчас доля влияния ссылочных факторов в Яндексе – меньше 30%. Есть четкая зависимость от поведенческих факторов – если сайт который находится по запросу в 20-тке при условии что у него хорошие поведенческие факторы ссылками вытянуть в топ можно, то при обратной ситуации – сайт зайдет в топ, но спустя пару апов поведенческих (1-3 месяца) все равно выпадет.

Ситуация в Google

По сравнению с Яндексом Гугл более архаичен. Поведенческие факторы тут работают, но не являются главными.

Долю влияния ссылочного на траст сайта я бы оценил в более 50%.

Остальные факторы – это текстовые, коммерческие и поведенческие.

В топ Гугла попасть без ссылок очень сложно.

Но последнее время Гугл начал плавно использовать метод оценки качества сайта кроме ссылок. Как пример – это использование метода оценки сайтов асессорами E-A-T (экспертность, авторитетность и надёжность сайта).

С 2015 года также работает Knowledge-Based Trust (КВТ) – алгоритм позволяющий проверять факты в текстах на истинность. Основа алгоритма – база в 2.8 миллиарда установленных факторов (основано на данных Википедии и других сайтов).

Даже сами ссылочные факторы совершенствуются. Например не так давно Google начал учитывать вложенность ссылок с релевантных страниц сайтов с высоким трастом по Knowledge-Based Trust(КВТ).

Как это работает на практике? В тематике формируются сайты с высоким КВТ(эдакие лидеры ниши). Далее для оценки качества других сайтов учитываются вложенность ссылок на другие сайты. Чем больше ваш сайт имеет ссылок с сайтов с высоким КВТ тем лучше в выдаче отображается ваш сайт. При этом учитываются не только прямые ссылки, но и ссылки через другие доноры на ваш сайт.

Как использовать данные на практике?

Для Гугла – нужно больше ссылок, желательно с сайтов которые являются лидерами в вашей тематике или пересекаются с вами по семантическому ядру. Так как ссылочные факторы очень сильны, то многие параметры определяющие ссылочный профиль хорошо работают. В качестве примера можно взять параметры Ахрефса DR и UR. Демо версию на 2 запроса можно проверить тут.

В то же время доля влияния ссылочного в Яндексе меньше 30%. Оценка качества донора только по ссылочному профилю устарела еще в 2013 году. Новых метрик так и не было введено и причина этому – полная деградация современного SEO продвижения. Многие компании не понимая как закупать ссылки под Яндекс просто отказались от закупки вообще. Закупка ссылок в биржах упала в разы и как следствие конкуренция снизилась и рынок просел.

Тем не менее существуют методы оценки качества донора с помощью оценки видимости в Яндексе. Сам метод не является панацеей, так как он не может определить причин падения трафика за счет устаревания контента.

К сожалению биржи ссылок не особо заинтересованы в методе оценки видимости на сайтах. А причина банальна – 95% сайтов в биржах не имеют позиций, а более 70 % просто под фильтрами и не годятся для закупки ссылок.

Я для себя использую свою программу для упрощения подбора доноров (с фильтром по Liveinternet,видимости Google и Яндекса).

По материалам devvver.ru